Industries we serve

When smart people use smart tech, expect extraordinary innovation. Customers in over 100 countries are changing the world every day. See how we support them.

Mining

Mining and exploration software that assists critical decisions across the project lifecycles.

Energy

Reduce risk from exploration to operation with industry-leading geothermal software.

Civil

Bring together geotechnical teams to communicate a shared understanding of civil projects.

Environmental

Bring together teams and data to make the most informed decisions for environmental challenges.

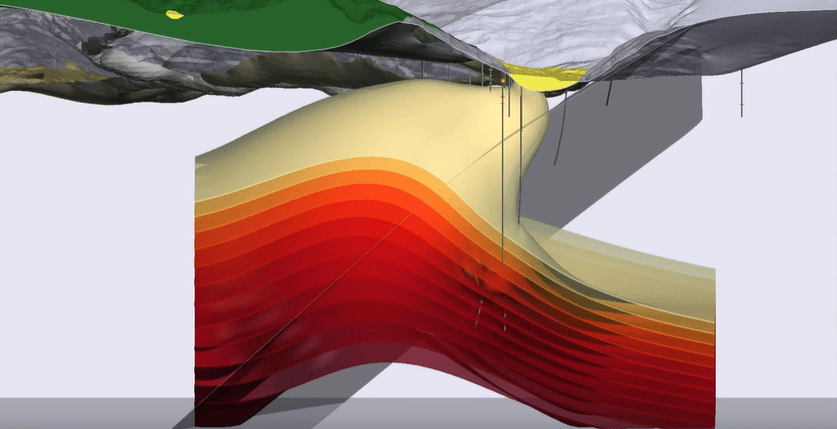

Hydrocarbon

Analyse, integrate, and collaborate with software for hydrocarbon industries.

Unexploded Ordnance

The trusted industry standard for assessment, analysis, and classification of UXO targets.

Industries we serve

When smart people use smart tech, expect extraordinary innovation. Customers in over 100 countries are changing the world every day.

See how we support them

Mining

Mining and exploration software that assists critical decisions across the project lifecycles.

Energy

Reduce risk from exploration to operation with industry-leading geothermal software.

Civil

Bring together geotechnical teams to communicate a shared understanding of civil projects.

Environmental

Bring together teams and data to make the most informed decisions for environmental challenges.

Hydrocarbon

Analyse, integrate, and collaborate with software for hydrocarbon industries.

Unexploded Ordnance

The trusted industry standard for assessment, analysis, and classification of UXO targets.

Industries we serve

When smart people use smart tech, expect extraordinary innovation. Customers in over 100 countries are changing the world every day. See how we support them

Mining

Mining and exploration software that assists critical decisions across the project lifecycles.

Energy

Reduce risk from exploration to operation with industry-leading geothermal software.

Civil

Bring together geotechnical teams to communicate a shared understanding of civil projects.

Environmental

Bring together teams and data to make the most informed decisions for environmental challenges.

Hydrocarbon

Analyse, integrate, and collaborate with software for hydrocarbon industries.

Unexploded Ordnance

The trusted industry standard for assessment, analysis, and classification of UXO targets.

Leapfrog Energy Case Studies

Green fuel from green power: How geothermal can produce hydrogen

Meager Creek Development Corp could be the first place to use geothermal energy to create green hydrogen and bring it to market taking a new approach to a well-known geothermal resource in Canada – using the earth’s energy to produce green hydrogen.

Leapfrog Energy Case Studies

Green fuel from green power: How geothermal can produce hydrogen

Meager Creek Development Corp could be the first place to use geothermal energy to create green hydrogen and bring it to market taking a new approach to a well-known geothermal resource in Canada – using the earth’s energy to produce green hydrogen.

“

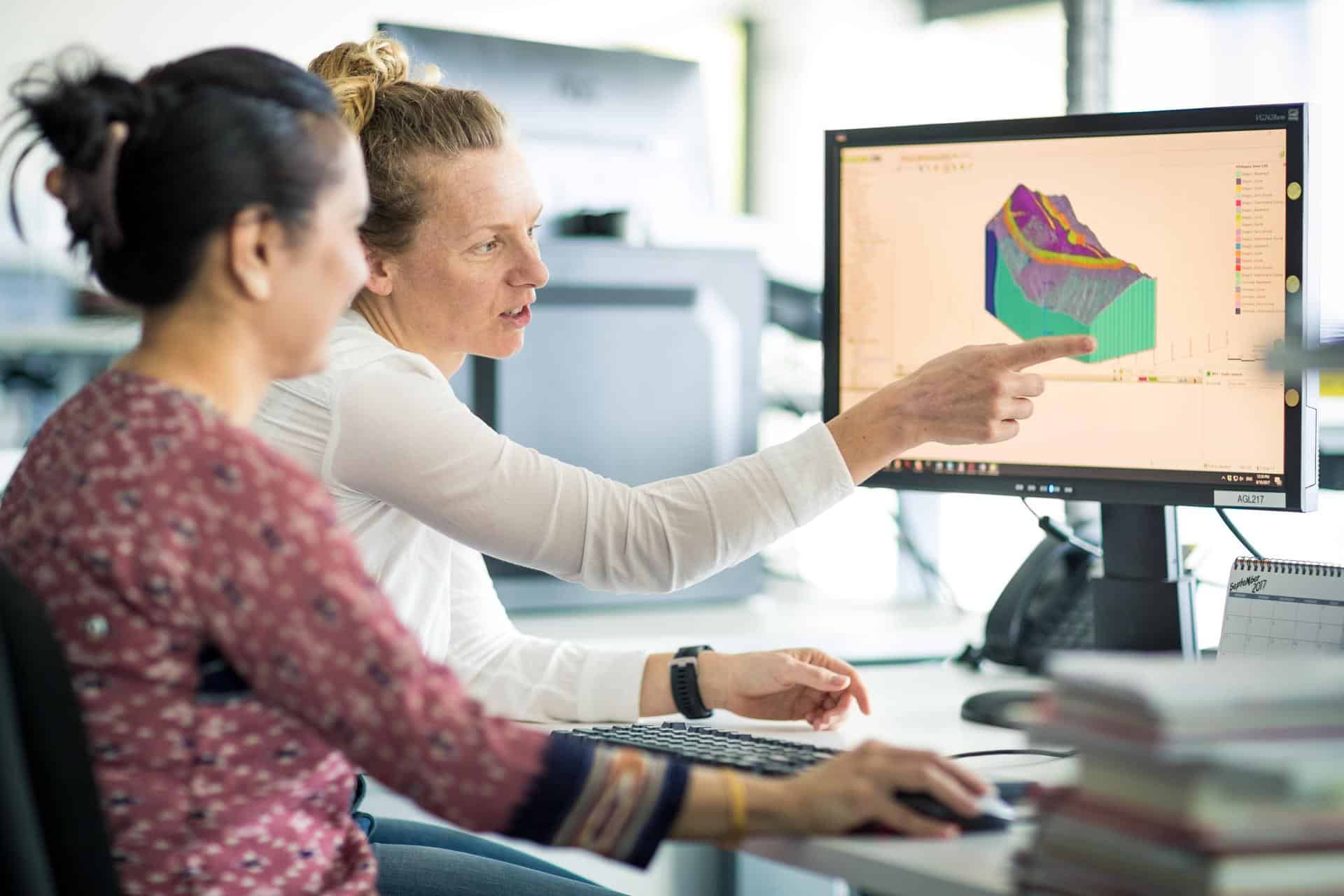

Seequent plays an important part in helping us to make our decisions based on truly understanding our geology... this is at the heart of what we do.

Nicolas Pirotte, Lhoist Group Geologist

“

Seequent plays an important part in helping us to make our decisions based on truly understanding our geology... this is at the heart of what we do.

Nicolas Pirotte, Lhoist Group Geologist

Seequent Events

Connect with our team of experts and learn more about our solutions at one of the many events held around the globe.

News & Events

Seequent Events and Training

Looking to find out more from our technical experts? Check out our extensive range of webinars for practical training and top tips to get the best from our solutions. Plus, we offer in-person and remote training options around the globe. Head to our Events and Training section.

Bring teams and data together with Seequent Central

Visualise, track, and manage your geo-data from a centralised, auditable environment.

Bring teams and data together with Seequent Central

Visualise, track, and manage your geo-data from a centralised, auditable environment.

Transform how you work: connect, collaborate,

and make better decisions

Seequent is trusted by top companies across industries to bring

together teams and integrate data.

Transform how you work: connect, collaborate,

and make better decisions

Seequent is trusted by top companies across industries to

bring together teams and integrate data.

“

We are deeply aligned with where our customers are going and where they want to go … supporting them but also leading, looking over the hill, determining what’s coming next.

Graham Grant, CEO Seequent

“

We are deeply aligned with where our customers are going and where they want to go … supporting them but also leading, looking over the hill, determining what’s coming next.

Graham Grant, CEO Seequent

Mining Success

March 1, 2022

How Wallbridge Mining accelerated their search for gold with Seequent Central and Leapfrog Geo

The collaborative power of Seequent Central and Leapfrog Geo was instrumental in getting those models created. It gave us so much opportunity to just test ideas, and if they didn’t work, jump to the next with real speed.

March 1, 2022

How Wallbridge Mining accelerated

their search for gold with Seequent

Central and Leapfrog Geo

The collaborative power of Seequent Central and Leapfrog Geo was instrumental in getting those models created. It gave us so much opportunity to just test ideas, and if they didn’t work, jump to the next with real speed.

At Seequent, there’s a place for every kind of brilliant

At Seequent, there’s a place for every kind of brilliant

Ready to change the world?

Join our global teams and work at the intersection of people and the planet. We are always interested in meeting good talented people to join our growing team.

Sound like the people and place for you?